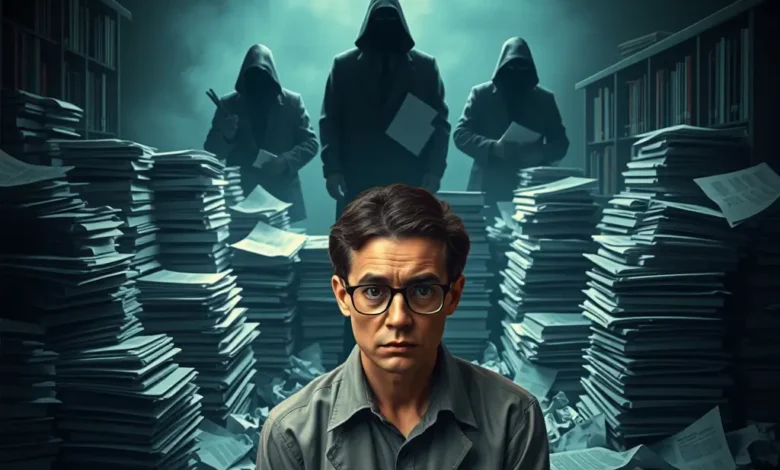

الغش بالذكاء الاصطناعي في الامتحانات الوظيفية: نحو بناء أطر قانونية وأخلاقية رادعة

مع التقدم الهائل في تقنيات الذكاء الاصطناعي، خاصة النماذج التوليدية مثل ChatGPT، ظهرت تحديات غير مسبوقة أمام مصداقية الامتحانات الأكاديمية والوظيفية.

أظهرت أبحاث حديثة قدرة هذه الأنظمة على اجتياز اختبارات معقدة مثل امتحانات الترخيص الطبي (Verywell Health, 2023)، مما يُبرز الحاجة الملحّة إلى تطوير أطر قانونية وأخلاقية جديدة لمواجهة إساءة استخدام الذكاء الاصطناعي، خاصة في سياق الغش في الامتحانات الوظيفية والمهنية.

- 1. الحاجة إلى تشريعات جديدة مخصصة

الدراسات تشير بوضوح إلى أن الأدوات التوليدية قادرة على أداء مهام تقييمية معقدة، مما يتطلب تشريعات مصممة خصيصا لضبط استخدام هذه التكنولوجيا في البيئات التعليمية والوظيفية (BMC Medical Education, 2023). يجب أن تشتمل هذه التشريعات على:

- تعريف دقيق لماهية “الغش بواسطة الذكاء الاصطناعي”.

- مسؤوليات الأفراد والمؤسسات في الكشف عن استخدام أدوات الذكاء الاصطناعي أثناء الاختبارات.

- عقوبات قانونية واضحة لمرتكبي الغش بالاعتماد على أدوات الذكاء الاصطناعي.

هذه القوانين ينبغي أن تتصف بالمرونة الكافية لمواكبة تطور هذه التقنيات، مع وضع قواعد للتمييز بين الاستخدام المشروع (مثل التدرب والتعليم) والاستخدام الاحتيالي (الغش والانتحال).

- 2. نماذج أولية لقوانين وسياسات جامعية وأكاديمية ناشئة (2024–2025)

تشير تقارير أكاديمية حديثة إلى بدء صياغة سياسات جامعية تُلزم الطلاب بالإفصاح عن استخدام الذكاء الاصطناعي (Health Science Reports, 2024). من بين أبرز التوجهات:

- إدراج بنود صريحة في لوائح النزاهة الأكاديمية تحظر استخدام أدوات الذكاء الاصطناعي بدون تصريح.

- إنشاء لجان رقابة متخصصة في تقييم انتهاكات استخدام الذكاء الاصطناعي أثناء الاختبارات.

- تطوير اختبارات مصممة خصيصا للحد من فاعلية الأدوات الذكية في دعم الغش.

نماذج من هذه السياسات بدأت بالظهور في بعض الجامعات الكبرى، التي باتت تعتبر اللجوء غير المصرح به إلى الذكاء الاصطناعي شكلا من أشكال الانتحال الأكاديمي.

- 3. مقترحات علمية لتقنين استخدام الذكاء الاصطناعي وضبطه

استنادا إلى البحوث التي تناولت توظيف الذكاء الاصطناعي في التعليم الطبي (BMC Medical Education, 2024)، يمكن تقديم مجموعة من المقترحات لتقنين وضبط استخدام الذكاء الاصطناعي:

- تقنيات الكشف المبكر: تطوير أدوات كشف متقدمة قادرة على رصد استخدام الذكاء الاصطناعي أثناء الامتحانات، عبر تحليل أنماط الإجابة والسلوك الرقمي.

- ترخيص استخدام الذكاء الاصطناعي: إلزام الطلاب والموظفين بالحصول على تراخيص أو تصاريح لاستخدام أدوات الذكاء الاصطناعي لأغراض محددة ومعتمدة.

- اختبارات تفاعلية حية: اعتماد نماذج تقييم تعتمد أكثر على التفاعل الحي والمراقبة المباشرة (Oral Exams, Practical Demonstrations) للحد من تدخل الذكاء الاصطناعي.

4. أهمية التوعية الأخلاقية والتدريب المبكر للطلاب والمتقدمين للوظائف

أشارت دراسات متعددة إلى وجود فجوة كبيرة في وعي الطلاب بأخلاقيات استخدام الذكاء الاصطناعي (BMC Medical Education, 2024). لذلك من الضروري:

- دمج مفاهيم النزاهة الأخلاقية: تضمين مساقات إلزامية في المناهج الدراسية حول الاستخدام الأخلاقي للتكنولوجيا.

- ورش عمل تدريبية: إقامة ورش عمل منتظمة للطلاب والموظفين لتعريفهم بمخاطر الغش بواسطة الذكاء الاصطناعي وأبعاده القانونية.

- حملات توعوية: تنفيذ حملات توعوية داخل المؤسسات الأكاديمية والمهنية لتعزيز ثقافة النزاهة والشفافية.

التوعية المبكرة تخلق بيئة تعليمية ومهنية أكثر التزاما، وتقلل من فرص استغلال أدوات الذكاء الاصطناعي في الغش والانتحال.

- خلاصة:

في ظل التطور المتسارع للذكاء الاصطناعي، يصبح بناء أطر قانونية وأخلاقية متكاملة ضرورة ملحّة لضمان نزاهة الامتحانات الوظيفية والأكاديمية. وتوصي هذه الدراسة بضرورة الإسراع في تبني تشريعات مخصصة، صياغة سياسات مؤسسية واضحة، اعتماد تقنيات كشف متطورة، وأخيرا الاستثمار في التوعية الأخلاقية المستدامة للطلاب والمهنيين.

قائمة المراجع:

-

ChatGPT Is Great at Taking Medical Licensing Exams. But Can It Replace Doctors? — Verywell Health.

- The challenges imposed by artificial intelligence: are we ready in medical education? | BMC Medical Education.

- Academic Integrity Within the Medical Curriculum in the Age of Generative Artificial Intelligence – PMC.

- Artificial intelligence in medical education – perception among medical students | BMC Medical Education.

- AI in medical education: uses of AI in construction type A MCQs | BMC Medical Education.